إن الديب فيك هي فيديوهات أو ملفات صوتية مزيفة تبدو حقيقية تمامًا. قديمًا، كانت هذه التقنية محصورة على الشركات العملاقة، أما الآن فبإمكان أي شخص تصميم فيديو يظهر شخصية مشهورة بوضع خلاعي أو جعل سياسي يقول نكات مضحكة. لحد الآن، فإن جميع تطبيقات الديب فيك محصورة بتطبيقات غير خطيرة كالأمثلة المذكورة سابقًا. ولكن هذه التقنية جعلت من السهل على أي شخص أن يصمم فيديو إنذار من حرب وشيكة أو أن يدمر حياة شخص بفيديو إباحي مزيف له أو أن يخرب الانتخابات بأن ينشر مقطعًا زائفًا لسياسي يقول أشياء كاذبة.

تسبب هذه السيناريوهات القلق للكثير من الناس، لدرجة أن السيناتور الأمريكي ماركو روبيو يعتبرها بخطورة الأسلحة النووية، إذ يقول: «قديمًا إذا أردت أن تهدد الولايات المتحدة الأمريكية ستحتاج لـ 10 حاملات طائرات وأسلحة نووية وصواريخ بعيدة المدى. اليوم، ستحتاج فقط للدخول إلى نظامنا للإنترنت، أو نظامنا البنكي، أو القدرة على إنتاج فيديوهات مزيفة واقعية جدًا قد تدمر انتخاباتنا وتضعفنا داخليًا».

لا يتفق الجميع على أن هذه الفيديوهات مرعبة لهذه الدرجة حقًا، إذ يقول تيم هوانغ، مدير مبادرة أخلاقيات وتنظيم الذكاء الاصطناعي في مركز Berkman-Klein ومخبر الإعلام في معهد ماساشوستس للتكنولوجيا: «لا أظن أن هذه التقنية بخطورة الأسلحة النووية أبدًا. أظن أن ما رأيناه مثير للقلق طبعًا ولكن لا أظن تأثير هذه التكنولوجيا سيكون دراماتيكيًا كما يصوره البعض».

كيف تعمل هذه التقنية؟

تستخدم هذه التقنية شبكتين عصبونيتين صناعيتين. الأولى تُدرّب للقيام بدمج الوجه المطلوب مع الفيديو، أما الثانية فتُدرّب للكشف عن الدمج المزور.

تعمل الشبكة الأولى حتى لا تستطيع الشبكة الثانية الكشف عن التزوير. كلما كانت البيانات التي ندرب الشبكة الأولى باستخدامها أكبر استطاعت أن تزور الفيديو بشكل أفضل. لهذا كان السياسيون والمشاهير هم الأهداف الأولى لهذه التقنية إذ أن صورهم وفيديوهاتهم منتشرة بكثرة.

تعتبر هذه الفيديوهات خطرة ولكن هناك نوعًا آخر من الفيديوهات الخطرة لا تحتاج لمهارات تقنية عالية، وتسمى بفيديوهات الشالو فيك.

أحد الأمثلة التي أثارت الانتباه في الآونة الأخيرة لهذه التقنية هو الفيديو الذي انتشر لمراسل الـ CNN جيم أكوستا والذي يقوم فيه المراسل بضرب موظفة في البيت الأبيض على الرغم من أن الفيديو الحقيقي يظهر أن الموظفة أتت لأخذ الميكروفون منه فحسب.

لا تستخدم هذه الفيديوهات شبكات عصبونية كفيديوهات الديب فيك، بل تعتمد على تعديل الفيديوهات بطرق لا تحتاج لمهارة تقنية عالية. ولكن، بدلًا من استبدال وجوه الناس أو جعلهم يقولون أشياء لم يقولوها فإن هذا النوع من الفيديوهات يقترب من الواقع أكثر ما قد يزيل الحد الفاصل بين الحقيقة والخداع.

كما أن هناك طرقًا لا تحتاج لأي مهارة تقنية على الإطلاق لنشر المعلومات الزائفة. مثلًا، التقاط فيديو لشخص يتعرض للضرب والتنمر ومن ثم الادعاء بأنه يتعرض لذلك لأنه مهاجر. الأمر يحتاج فقط لرواية قصة كاذبة حول الفيديو.

إن تقنية الديب فيك ليست مجرد أداة لوضع وجوه المشاهير في الأفلام الخلاعية، إذ تعتبر هذه التقنية قفزة هائلة في مجال من الذكاء الاصطناعي تُدعى بالتعلم غير المراقب (unsupervised learning) إذ تتعلم الشبكة العصبونية لوحدها. يمكّننا هذا من بناء سيارات ذاتية القيادة أفضل، وجعل المساعدين الصوتيين أكثر طبيعية.

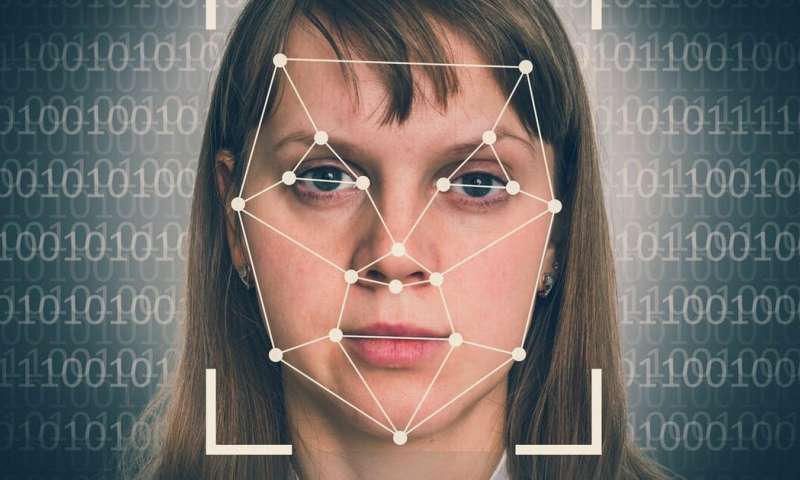

كيف يمكننا تحديد فيديوهات الديب فيك ؟

يمكن تحديد الفيديوهات المصممة من قبل الهواة بالعين المجردة، كما يمكن تحديد الفيديوهات الأكثر احترافية من قبل برامج قد تلاحظ غياب طرف العين أو أن الظلال غير متطابقة. كلما أصبحت التقنية أفضل احتجنا للاعتماد على التحليل الجنائي الرقمي، وفي مرحلة ما قد يصبح ذلك مستحيلًا.

إن هذه المشكلة معقدة لدرجة أن وكالة الأبحاث العسكرية الأمريكية صرفت الكثير من الأموال لإيجاد طرق لتحديد هذه الفيديوهات ولكن بإمكاننا من حيث المبدأ أن نعلّم الشبكات العصبونية كل الطرق التي نستعملها للكشف عن هذه الفيديوهات وبالتالي تستطيع اجتياز جميع الاختبارات التي سنقوم بها.

هذا يثير قلق السياسيين، ولكن لهوانغ رأي آخر إذ يرى أن الضجة حول هذه الفيديوهات هي أكبر حماية منها إذ أننا نعرف أنه يمكن عمل هكذا فيديوهات وبالتالي لا ننخدع بها.

كيف يمكننا تنظيم هذه التقنية ووضع قوانين لاستخدامها؟

في الحقيقة، هذه مسألة صعبة جدًا وتختلف من شخص لآخر ومن دولة لأخرى، وما يزال السياسيون يناقشون ما يجب فعله.

أزالت المواقع الإباحية المشهورة هذه الفيديوهات لأنها تخالف قوانين استخدامها.

اقرأ أيضًا:

ممارسة ألعاب الفيديو تزيد كمية المادة الرمادية والاتصالات الدماغية

بمساعدة ربع مليون من محبي ألعاب الفيديو، اكتشاف ستة أنواع جديدة من الخلايا العصبية

ترجمة: مهران يوسف

تدقيق: جعفر الجزيري